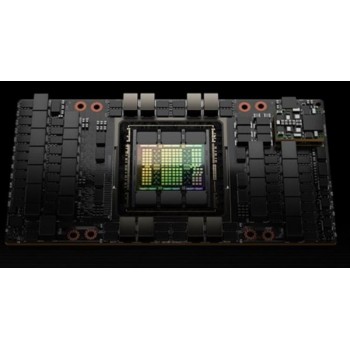

NVIDIA英伟达H800人工智能服务器为各类数据中心提供出色的性能、可扩展性和安全性。

加速计算的数量*飞跃

通过 NVIDIA英伟达H800人工智能服务器 GPU,在每个工作负载中实现出色性能、可扩展性和安全性。使用 NVIDIA® NVlink® Switch 系统,可连接多达 256 个 H800 来加速百亿亿* (Exascale) 工作负载,另外可通过专用的 Transformer 引擎来处理万亿参数语言模型。与上*代产品相比,H800 的综合技术创新可以将大型语言模型的速度提高 30 倍,从而提供业界**的对话式 AI。

准备好迎接企业 AI 了吗?

企业采用 AI 现已成为主流,企业组织需要端到端的 AI 就绪型基础架构,加快自身迈向新时代的步伐。

适用于主流服务器的 H800 随附五年期 NVIDIA AI Enterprise 软件套件订阅(包括企业支持),能够以强大的性能简化 AI 的采用。这可确保组织能够访问构建 H800 加速的 AI 工作流所需的 AI 框架和工具,例如 AI 聊天机器人、推荐引擎和视觉 AI 等。

NVIDIA英伟达H800人工智能服务器GPU算力租赁配置:

|

项目 |

标准配置 |

|

框架 |

8U 机架式服务器 |

|

处理器 |

2颗*4代/*5代至强系列*高 64 核/3.9GHz/320MB缓存 |

|

内存 |

*大容量 4TB |

|

GPU |

NVIDIA HGX H800 GPU模组 |

|

系统硬盘 |

M.2 NVMe PCIe接口 2TB SSD |

|

数据硬盘 |

2*10TB 企业* SATA 硬盘 RAID 10 阵列配置 |

|

InfiniBand 网络 |

ConnectX-7 400Gb/s |

|

Ethernet 网卡 |

OCP 网卡/双电口/10G |

|

PICE 插槽 |

9 个 PCIe 5.0 扩展插槽 |

|

电源 |

6*3000W,2*2700W,AC220 输入 |

|

风扇 |

10 个 54V 风扇模组 |

|

操作系统 |

Windows Server/RedHat Enterprise Linux/SUSE Linux Enterprise Server/CentOS/Ubuntu/Vmware EXSi |

|

工作温度 |

+5°~+35° |

|

其他接口 |

机箱后部:1 个 RJ45 管理接口,2 个 USB 3.0,1 个 VGA 机箱前部:2 个 USB 3.0,1 个 VGA |

|

整机净重 |

120KG(以实际配置为准) |

NVIDIA H800 TENSOR CORE GPU 规格 (SXM4 和 PCIE 外形规格)

|

外形规格 |

H800 SXM4 |

H800 PCIE |

|

FP64 |

1 teraFLOPS |

0.8 teraFLOPS |

|

FP64 Tensor Core |

1 teraFLOPS |

0.8 teraFLOPS |

|

FP32 |

67 teraFLOPS |

51 teraFLOPS |

|

TF32 Tensor Core |

989 teraFLOPS* |

756teraFLOPS* |

|

BFLOAT16 Tensor Core |

1979 teraFLOPS* |

1,513 teraFLOPS* |

|

FP16 Tensor Core |

1979 teraFLOPS* |

1,513 teraFLOPS* |

|

FP8 Tensor Core |

3958 teraFLOPS* |

3026 teraFLOPS* |

|

INT8 Tensor Core |

3958 TOPS* |

3026 TOPS* |

|

GPU 显存 |

80GB |

80GB |

|

GPU 显存带宽 |

3.35TB/s |

2TB/s |

|

解码器 |

7 NVDEC/7 JPEG |

7 NVDEC/7 JPEG |

|

*大热设计功率 (TDP) |

高达 700 瓦(可配置) |

350 瓦(可配置) |

|

多实例 GPU |

*多 7 个 MIG @每个 10GB |

|

|

外形规格 |

SXM |

PCIe双插槽风冷式 |

|

互联技术 |

NVlink:600GB/s PCIe:128GB/s |

NVlink:600GB/s PCIe:128GB/s |

安全地加速从企业*到百亿亿次*规模的工作负载

实时深度学习推理

超大模型的 AI 推理性能提升高达 30 倍

HPC 应用的性能提升高达 7 倍

百亿亿次*高性能计算

加速数据分析

为企业提高资源利用率

内置机密计算

为大规模 AI 和高性能计算提供出色的性能